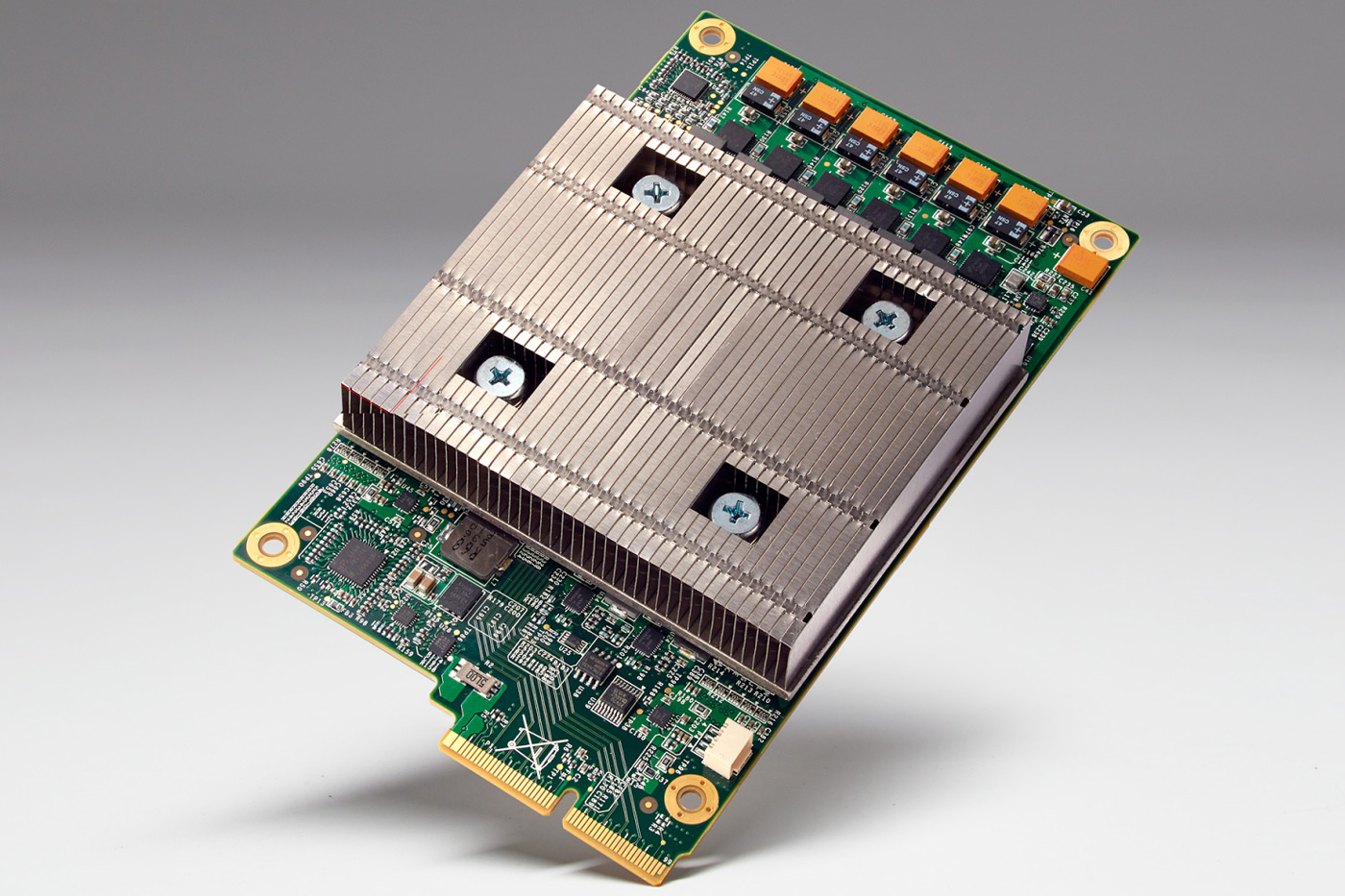

Google “Yapay Zeka Odaklı” yeni işlemcisi TPU’yu duyurdu.

Donanım üretme sevdası pekte yeni olmayan teknoloji devi makina öğrenimini hızlandıracak yeni işlemcisi ile karşımıza çıkıyor.

Google’ın I/O 2016 geliştirici konferansında satır aralarında yer bulan aslında bir o kadarda önemli olan özel tasarımlı yeni işlemci TPU “Tensor Processing Unit” şirketin yapay zeka servislerine hizmet edecek.

Makine öğrenimine yeni bir ivme, yapay zekaya hız katacak.

İşlem kabiliyetinin son derece yüksek olduğunu belirten Sundar Pichai, Tensor işlemcinin watt başına düşen performansta ticari rakipleri FPGA ve GPU işlemcilerini oldukça geride bıraktığını belirtti.

Google’ın yeni işlemcisi raf tipi sunucularda sabit disk slotuna sığacak ölçülerde tasarlanmış ve AI yani Yapay Zeka servislerinde kullanılacak.

Bunlar arasında StreetView, Inbox ve Asistan gibi bilinen uygulamalar da var.

Google TPU , Tensor İşlemciyi Neden Tasarladı ?

Tensor işlemcisi görünüşe bakılırsa yapay zeka uygulamaları ekseninde 16-bit kayar nokta hesaplamaları için özelleştirilmiş. Analistlerin tahmini de daha az karmaşık matematik hesaplamarı gerektirdiği için yeni işlemcinin eğitimden ziyade öğrenim üzerine yoğunlaşmış olduğu söyleyebiliriz.

Yine de Google’ın yeni işlemcisi yapay zeka için tek başına yeterli bir platform oluşturmuyor.

Yüksek başarımlı bilgi işlem hızlandırıcı kartlar ki Nvidia’nın henüz tüketici sınıfında yani GeForce serisi ekran kartlarında kullanmadığı Pascal tabanlı devasa GP100 GPU grafik işlemcilerini kullanan Tesla sınıfı kartlarda bu yapı içerisinde kullanılıyor olabilir.

Google doğal olarak TPU , Tensor işlemcilerini veri merkezlerinde kullanacak. Raf tipi sunucuların sabit disk yuvalarına sığan bu işlemci sayesinde arama sonuçlarının ilişkilendirmesi, harita ve konum belirleme servislerinin hassasiyet ve genel hizmet kalitesinin yükseltilmesinde önemli rol oynamış.

Şirket mühendisleri yeni Google TPU işlemcisi sayesinde yapay zeka hızı ve tahmin yeteneklerinin önemli ölçüde hızlandığını belirtiyor.